Има безкрайно много причини, поради които човек или компания ще искат да използват робот софтуер. Този тип програми сърфира в интернет в един определен начин, който може да бъде автоматизирано, методичен или по организиран начин. Ако не сте запознати с термина робот софтуер, може би сте чували за паяци, ботове, мравки, автоматични индекси, роботи или scutters? Всички те са в основата на едно и също нещо!

Целта на Web Crawler Software

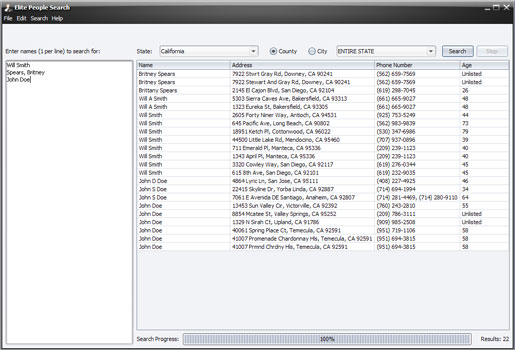

Когато мислите за уеб пълзи софтуер, най-вероятно си представя големите търсачки като Google име, Bing и Yahoo. Техните ботове пълзи през уеб страници, за да се определи съдържанието, значение и индексиране. Чрез създаването на копие на посетените страници, те могат да осигурят по-бързи и по-точно търсене. SqrBox ще ви кажа, че със сигурност не е нужно да бъде търсачката да има нужда от робот софтуер. Ти просто трябва да бъде някой, който има нужда да се съберат големи количества или изключително сложна информация.

Видове Web Crawler Software

Ако планирате да използвате услугите на професионална компания като SqrBox, наистина не трябва да се занимава с цялата сложна жаргона отношение робот софтуер. И все пак, това е полезно да се разбере някои неща за него.

Фокусирани Crawling - Целта на този тип робот софтуер е да изтеглите страници, които се появяват, за да съдържа подобна информация. Често има някои недостатъци, свързани с този метод макар и действителното изпълнение на робота и резултата са зависими от това колко богата на връзките са на тази конкретна тема, която се търси. Този вид робот софтуер често се използва като отправна точка, за да стесните търсения за по-нататъшно пълзи.

URL Нормализиране - робот софтуер често ще извърши някакво ниво на URL нормализация, който помага за намаляване на повтарящи обхождането на същия източник на повече от един път.

Ограничаване Следени Links - В някои случаи, робот софтуер може да искате да се избегне някои уеб съдържание и само търсят .html страници. За да направите това, на URL често се разглежда и след това средства ще бъдат поискани само ако са налице определени символи в URL адреса, като .html, .asp, .htm, .php, .aspx, .jspx или .jsp. робот софтуер обикновено ще игнорира ресурси с "?" . да се избегне капаните паяк

<силни> Изисквания :

.NET Framework 3.5

Коментари не е намерена